马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

本帖最后由 lazy心宿 于 2018-3-12 10:06 编辑

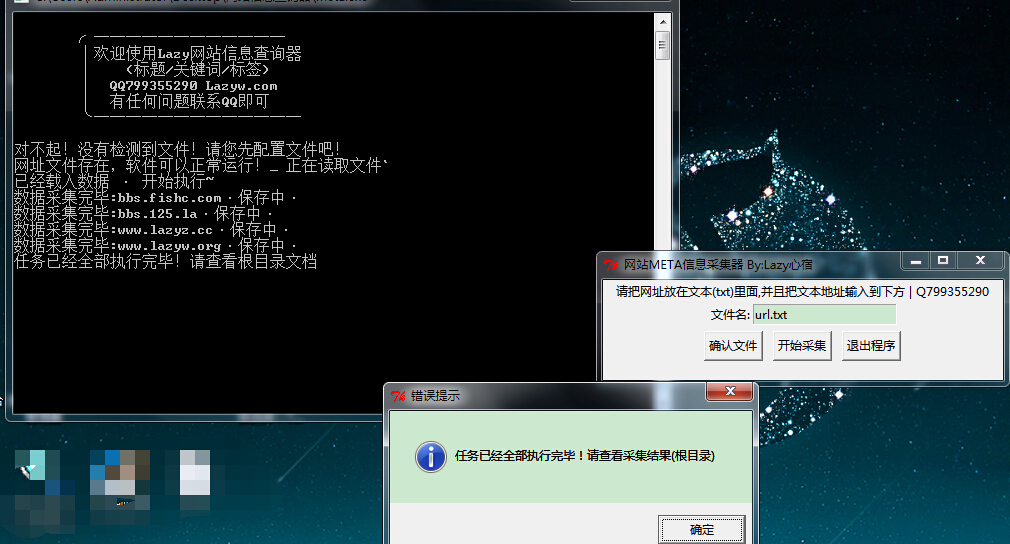

Python:网站信息批量采集工具,标题,关键词,描述信息等此软件为本人刚学python开发的第一个成品软件,个人感觉还是不错的,只是对urllib2的模块使用不是很熟练,其实也觉得没啥,毕竟易语言我用的就是winhttp的对象协议,觉得相对比较好理解,展示一下成品,之后给大家开源(暂时没找到开源区)

本程序由 Python开发, 暂时360 以及管家均未报毒,360提示拦截网络访问了,不过程序没有任何后面,添加信任即可!

本软件为完全免费软件,不会收取任何费用,希望可以给您带来便捷的工作!

切记:本程序主程序为:meta.exe 使用就打开它 没错

(此文件为主程序,其他文件也不可以删除或者丢失!)

使用说明:

1、打开软件之后,会提示你输入文本的路径。

2、你只需要把要查询的网址,一行一个的保存成txt即可,然后把文本位置输入到软件内

(如果是在软件根目录,就只需要输入名称即可!)

3、点击确认文件 - 会提示你相应的错误或者继续的步骤

4、在确认文件已经被软件导出成功的情况下,点击 开始采集 即可!

5、在后方的日志窗口,会有输出网址的信息保存情况!可以实时监控软件当前的状态!

如果软件执行完毕,会在日志以及信息框提示您任务已经全部完成!

注意:任务完成后,软件会自动把信息保存在根目录:Lazy查询结果.txt 的文档内。

文件保存的格式为:网址----标题----关键词----介绍 一行一个保存

——————————————————————————————

成品下载地址:链接:https://share.weiyun.com/c30e89b5e1fd79de524d706f9d807d05 密码:t8th6d

下载地址已经更新 有问题回帖告诉我就好啦

|  ( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)