|

|

马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

本帖最后由 小古比鱼 于 2020-11-25 21:34 编辑

IRIS数据集:

- import tensorflow as tf

- from sklearn import datasets

- import numpy as np

- x_train = datasets.load_iris().data

- y_train = datasets.load_iris().target

- np.random.seed(116)

- np.random.shuffle(x_train)

- np.random.seed(116)

- np.random.shuffle(y_train)

- tf.random.set_seed(116)

- model = tf.keras.models.Sequential([

- tf.keras.layers.Dense(3, activation='softmax', kernel_regularizer=tf.keras.regularizers.l2())

- ])

- model.compile(optimizer=tf.keras.optimizers.SGD(lr=0.1),

- loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),

- metrics=['sparse_categorical_accuracy'])

- model.fit(x_train, y_train, batch_size=32, epochs=500, validation_split=0.2, validation_freq=20)

- model.summary()

MNIST数据集:

- import tensorflow as tf

- mnist = tf.keras.datasets.mnist

- (x_train, y_train), (x_test, y_test) = mnist.load_data()

- x_train, x_test = x_train / 255.0, x_test / 255.0

- model = tf.keras.models.Sequential([

- tf.keras.layers.Flatten(),

- tf.keras.layers.Dense(128, activation='relu'),

- tf.keras.layers.Dense(10, activation='softmax')

- ])

- model.compile(optimizer='adam',

- loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),

- metrics=['sparse_categorical_accuracy'])

- model.fit(x_train, y_train, batch_size=32, epochs=5, validation_data=(x_test, y_test), validation_freq=1)

- model.summary()

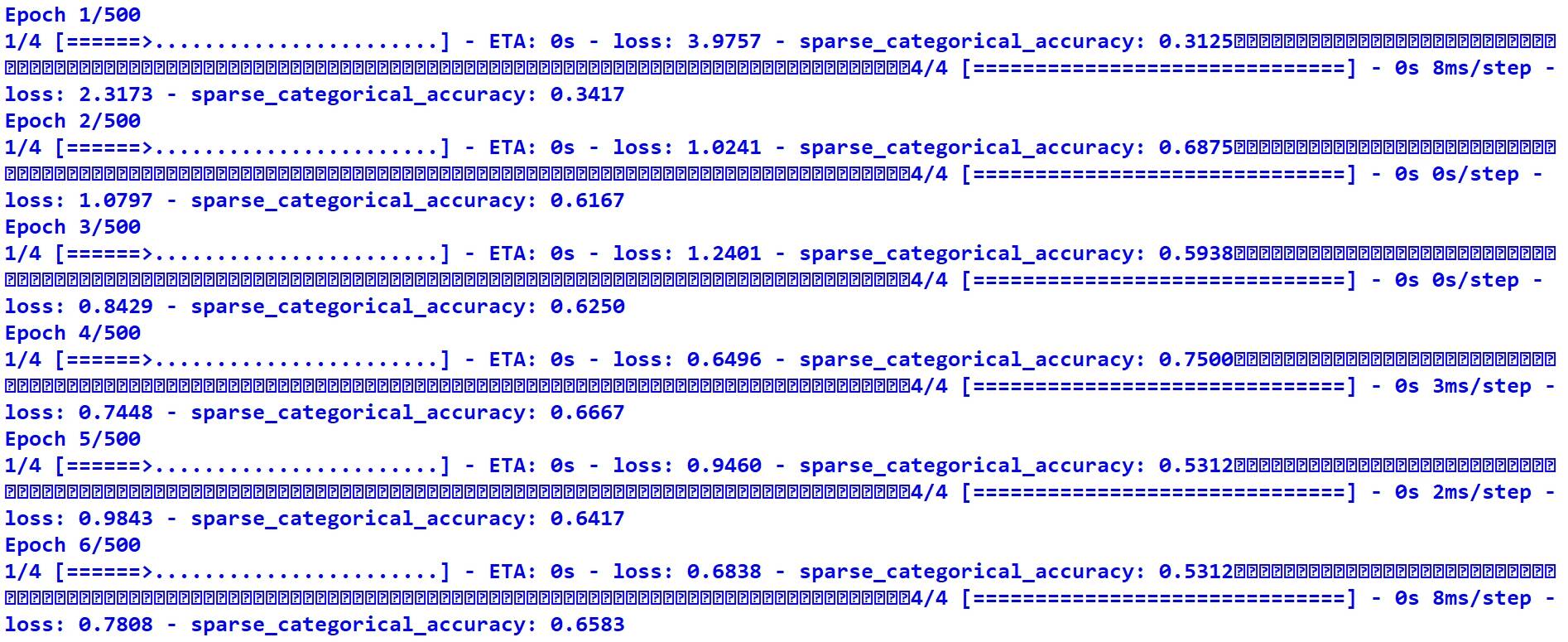

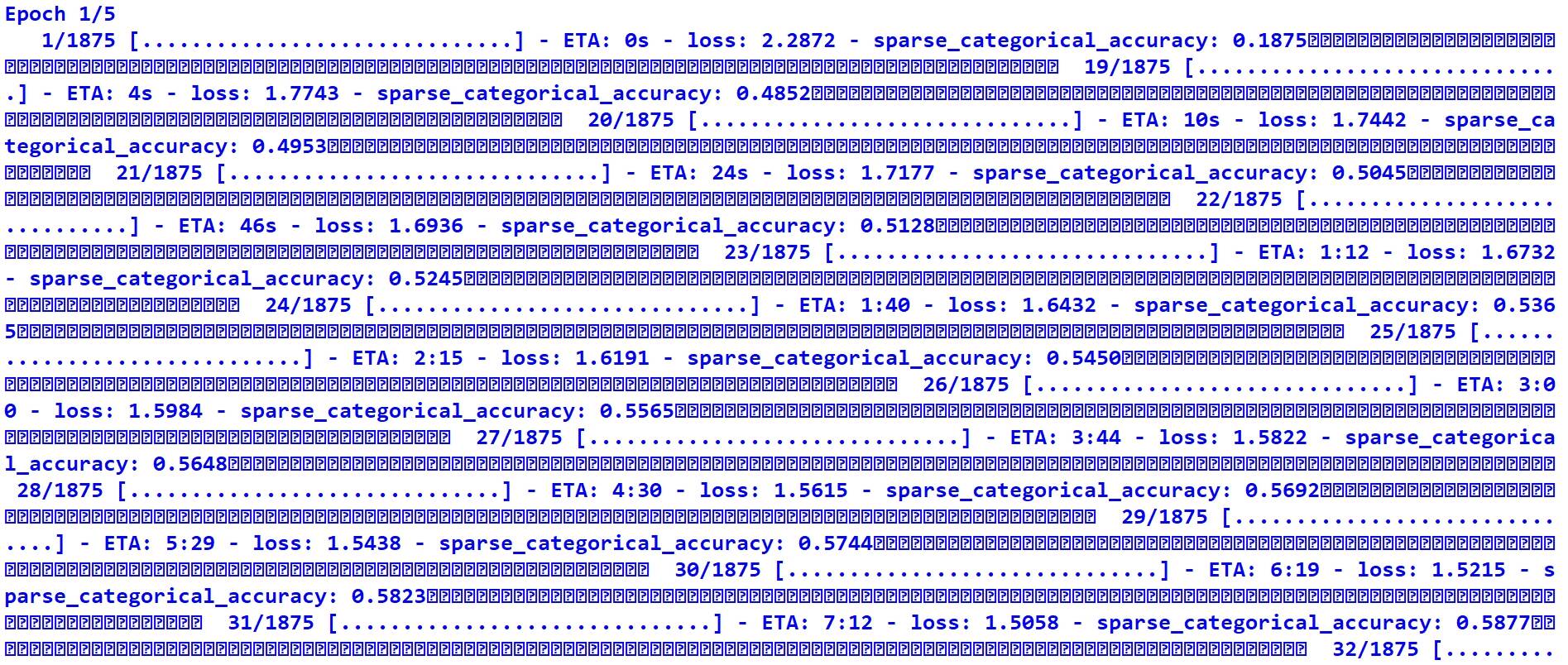

这两段代码在执行到“model.fit()”一句时训练速度极慢,输出内容如图所示,剩余时间越来越长,明显有问题,请问是否因为没有GPU或非Anaconda环境的缘故?若将代码复制到Jupyter Notebook上运行则会快得多,十几秒钟就跑完了,真奇怪……

【注】我已经将MNIST数据集手动下载并存放在了系统盘的相应文件夹(C:\Users\用户名\.keras\datasets),为什么它运行的时候还要下载啊? |

-

IRIS数据集

-

MNIST数据集

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)