|

|

马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

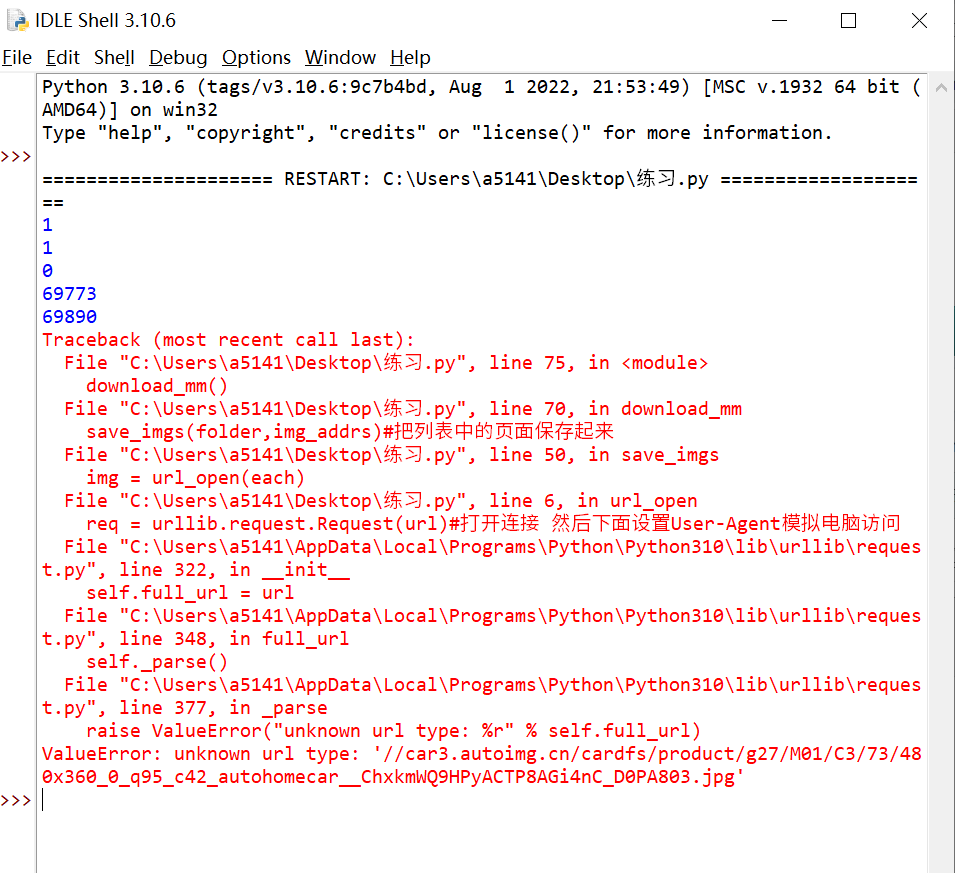

这个是哪里出错了大佬们

代码:

- import urllib.request

- import os

- def url_open(url):

- req = urllib.request.Request(url)#打开连接 然后下面设置User-Agent模拟电脑访问

- req.add_header('User-Agent','Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/113.0.0.0 Safari/537.36')

- response = urllib.request.urlopen(url)#打开网址

- #print(url)

- html = response.read()

- return html

-

- def get_page(url):

- html = url_open(url).decode('gb2312','ignore')#编码

- a = html.find('<a class="current" href="javascript:void(0)">')+45

- #print(a)

- b = html.find('<',a)

- #print(b)

- print(html[a:b])

- return html[a:b]

- def find_imgs(url):

- html = url_open(url).decode('gb2312','ignore')

- img_addrs = []

- a = html.find('img src=')

- print(a)

-

- while a != -1:

- b = html.find('.jpg',a,a+255)

- print(b)

- if b != -1:

- img_addrs.append(html[a+9:b+4])

- else:

- b = a+9

- a = html.find('img src=',b)

- for each in img_addrs:

- #print(each) #打印找到的图片地址

- return img_addrs

-

- def save_imgs(folder,img_addrs):

- for each in img_addrs:

- filename = each.split('/')[-1]

- with open(filename,'wb') as f:

- img = url_open(each)

- f.write(img)

-

- def download_mm(folder='OOXX',pages=20):

- os.mkdir(folder)

- os.chdir(folder)

- url = 'https://car.autohome.com.cn/pic/series/6388-10.html'

- page_num = int(get_page(url))

- print(page_num)

- for i in range(pages):

- page_num -= i #每个图片地址的页码

- page_url = 'https://car.autohome.com.cn/pic/series/6388-10-p' + str(page_num) + '.html'#重新拼成一个地址 页码-1

- print(i)

- img_addrs = find_imgs(page_url)#把图片的地址保存成列表然后返回

- save_imgs(folder,img_addrs)#把列表中的页面保存起来

-

-

- if __name__ == '__main__':

- download_mm()

-

-

- #https://car.autohome.com.cn/pic/series/6388-10-p2.html

本帖最后由 阿奇_o 于 2023-10-1 02:46 编辑

一步步来,才比较好确定哪里出错了。。

先搞定一页(第一页共60张图),建议用正则表达式来查找img(或bs4等解析后用css选择器等也行),这样更方便,比如:

- html = resp.decode(encoding='gb2312', errors='ignore')

- import re

- pattern = '<img src="(.*?)" alt="2023款 .*?" title="(2023款 .*?)">'

- imgs = re.findall(pattern, html)

- print(len(imgs))

- print(imgs)

其次,考虑到图片较多,最后应该改为用 异步下载 的方式(aiohttp+asyncio),这个你可以自己研究一下,会让有一定难度。

最后,再解决 翻页 等问题。。

ps: 对了,正则获取到的图片的url,需要自己加上 协议名!!比如: - img_urls = ['https:' + i[0] for i in imgs]

|

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)