|

|

马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

- 第一次人工智能狂潮:推理与搜索

1956年夏天,在美国东部达特茅斯,由麦卡锡发起、联合香农、明斯基、纽厄尔、西蒙等数十名来自数学、心理学、神经学、计算机科学与电气工程等各种领域的学者聚集在特茅斯学院。

召开了一次具有传奇色彩的学术会议,会上首次正式出现了“人工智能”这个术语。

在那里,人们首次决定将像人类那样思考的机器称为“人工智能”。

当时,距离世界上第一台多用途的、使用了超过1.7万个真空管的巨型计算机ENIAC问世刚刚过去10年。

人们在亲眼看见了计算机强大无比的计算能力之后,便理所当然地认为:

终有一天计算机将会变得比人类更聪明、其能力将会凌驾于人类之上。

于是开展了一个接一个的“野心勃勃”的研究计划。

在这个时期,唱主角的是“推理”和“搜索”。

推理是将人的思维过程用符号来表示,然后加以运行的方法,从处理方法来讲,与搜索很接近。

因此在这里就讲讲搜索吧。

什么是搜索呢,大家想想迷宫问题就很容易理解。

假设有一个迷宫问题,由人来解答的话。

一般都会用手指或者铅笔朝着终点目标,沿着路线一边画线一边移动,直到无法前进为止。

让计算机这么做不太现实。

于是它给各个点标上字母符号,在道路分叉点设置节点,并且也标上字母符号,在无法前行处也标上字母符号。

于是,计算机按照这种方式将所有的解题模式全部排列出来,便得到了图中下面部分的图形表示。

这个图便被称作“搜索树”。

搜索树,说白了就是“情形区分”。

往这边走的情形,与往那边走的情形,对它们进行区分。

然后,到了这边之后,还要继续往下区分不同的情形。

这样不停地区分下去,早晚总会出现作为目标的条件。

计算机很单纯,只要指示它不断地进行这种区分,那么它就会不厌其烦地去执行。

这样,不知不觉地就找到了答案。

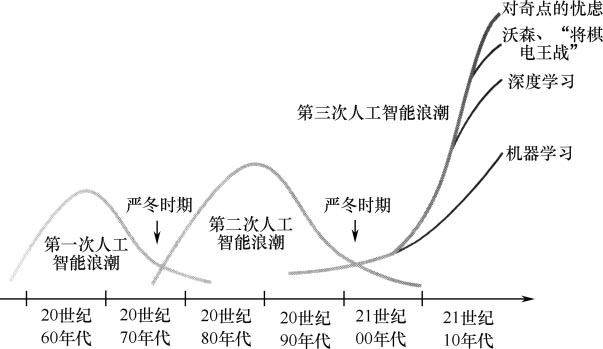

凭借强大的推理与搜索能力,第一次人工智能浪潮在20世纪60年代大放异彩。

当时,各种貌似很需要智慧的课题,都被计算机一个接一个地攻克和解决了。

于是,人们禁不住赞叹:

计算机真是太聪明了!

可是只要我们冷静地思考就会发现,这个时期的人工智能,其实能解决的问题非常有限。

求解迷宫问题,或者疑难定理的证明、赢得国际象棋比赛等专业性极强的内容,对计算机来讲其实非常简单。

这些都只需要在明确定义好的规则中考虑下一步如何走棋即可,然而要解决现实生活中的问题却困难重重。

例如,有个人生病了,有什么治疗方法吗?

或者,某个公司为了今后的发展需要开发些什么产品比较有效呢?

像这类我们日常生活中真正需要解决的问题,计算机却完全无能为力。

于是,大家逐渐明白了:

哦,原来计算机只能用推理和搜索来解决所谓的“玩具问题”(toyproblem)。

用计算机来实现人工智能其实是一件极其深奥的事情。

人们正是在第一次人工智能浪潮时期领悟到这点的。

并且还存在着我在人工智能在厉害,总有个硬伤!这里介绍到的逻辑悖论。

- 第二次人工智能狂潮:知识

即便能够解决所谓的“玩具问题”,却解决不了现实问题。

当人工智能这种局限性暴露出来后,相关研究在20世纪70年代一度变得萧条冷寂。

但到了20世纪80年代,它再度得势卷土重来。

与以往不同的是,这次它开始被应用于工厂的生产车间等现实产业领域。

与利用推理和搜索等简单规则来实现人工智能的第一次人工智能浪潮不同。

第二次人工智能浪潮依靠的是“知识”的支撑。

例如,如果想用它取代医生,那么只需将“大量的病理知识”输入计算机即可;

如果希望它取代律师的工作,那么输入“大量的法律知识”即可。

这样,它能解决的就不再是迷宫等玩具问题。

而是诊断病情,或者根据判例做出法律解释等现实问题。

这看起来的确很聪明,而且好像也蛮实用。

这其中,一个很有名的专家系统是20世纪70年代初期由斯坦福大学开发的MYCIN。

MYCIN的功能设计是对传染性血液病患者进行诊断,并开出处方。

我们向它内部输入500条规则,只需要按顺序依次回答其提问。

系统就能够判断出病人所感染细菌的类别,并为其开出对症的抗生素药方。

从性能上来讲,MYCIN开出正确处方的概率为69%。

其成绩优于非细菌感染专业的医师,但是与专业医师(正确率为80%)相比仍有差距。

这样的专家系统虽然有很多成功例子,但也存在一些问题。

当需要处理更为广泛领域的知识时,知识描述的难度会陡然增大。

例如,总感觉肚子有些疼痛,或者觉得胃部附近有些恶心等。

类似这类“模糊症状”的诊断,对计算机来讲难度就很大。

为什么呢?

“肚子”指的是哪儿?

“疼痛”具体是什么样的疼法?

“胃部附近”具体指哪个部位?

“有些恶心”具体指什么状况?

对这些问题都需要做出明确的定义。

这样一来,计算机就需要事先对人的身体结构及人的生物特征有一定程度的掌握和了解。

人有双“手”和双“脚”,“肚子”里面有“胃”“小肠”“大肠”。

“疼得打滚”和“疼得冒虚汗”疼痛程度的不同……

计算机必须具备这类常识性知识。

然而,这种“常识性知识”却恰恰是难以攻克的对象,其困难程度超乎我们的想象。

因为人类所拥有的一般性知识太多了,无论怎么输入也没有尽头。

但计算机要处理一般性常识,就需要先手动输入人类所拥有的、永远也无法写尽的海量知识。

这无疑是极为困难的。

- 第三次人工智能狂潮:机器学习和深度学习

在第二次人工智能浪潮的时候,只要往计算机里输入足够多的知识,它就能相应地完成很多事情。

但是其能力也仅限于所输入知识的范围之内。

而且,如果打算扩充其实用性及应对例外情况,则需要输入海量知识,永远也输不完。

然而,在这种闭塞的条件下,有一项技术却得到了稳步发展:

为什么机器学习突然可以发展起来?

这要归功于

文字识别模式积累基础 + 大数据

经ARPA网等技术发展,互联网网页首次出现在1990年。

更多详情,请看此文:互联网之父的争论与解答 - 【全网独家】

早期较为有名的浏览器Mosaic出现于1993年,谷歌的搜索引擎诞生于1998年。

消费者购物数据及医疗数据等数据挖掘研究变得盛行,相关国际性协会组织的诞生也同样是在1998年。

其中,尤其在互联网网页的猛烈影响下,处理网页文本的自然语言处理和机器学习的研究获得了很大发展。

随着互联网数据的不断积累,我们终于拥有了海量数据,下面就是“机器学习”的舞台了。

什么是机器学习?

首先请大家先思考一下学习的含义吧,怎样才算学到了东西呢?

学习的主要工作其实是进行“区分”,即对某一事物进行判断和识别。

如果我们能够进行正确的“区分”,那么就能理解这些事物,还能对其进行判断并采取相应的行动。

这里的“区分”,也就是“回答是‘Yes’还是‘No’的问题”。

例如,当我们看见一件东西的时候,便想知道它是否能拿来食用。

这就是一个“Yes/No问题”。

某样东西,我们想知道它到底是蛋糕、寿司还是乌冬面呢?

这个我们可以把它看作三个“Yes/No问题”。

可否把钱借给某人?

某个项目可否放行?

针对某个用户可否打出某个广告?

这类判断全部可以归结为“Yes/No问题”。

生物为了自身的生存,就对世界进行着区分处理。

能吃还是不能吃?

是敌人还是朋友?

是雄性还是雌性?

我们人类,因为拥有更高度的智能,所以对世界的分化处理更细致,有时细得甚至让人觉得没有意义。

综上所述,人类所涉及的识别及判断,基本上都可以被看作“Yes/No问题”。

对这些“Yes/No问题”回答正确率的提高过程,就是我们所说的“学习”。

通过机器学习,计算机将自动对事物进行判断和识别,进而可以做出预测。

这项技术在web及大数据领域已经运用得相当广泛。

但是,机器学习也有其弱点。它的弱点就在于如何选取“特征量”作为判断的标准。

选取什么作为特征量将决定预测精确度的高低,这个道理拿年收入预测问题来举例就很容易理解。

居住在何处?

是男性还是女性?

身高是多少?

从事什么行业?

从这类特征量出发来预测年收入,我们通过机器学习方法能够对此进行区分。

这时候,选取什么作为特征量,换言之,即读取什么变量,将在很大程度上决定预测的精确度。

举个例子,如果通过行业和居住地判断,Yes/No的判断会很准;

如果通过身高和性别判断,Yes/No的判断结果的精确度会差很多。

但是,计算机并不能做出选取特征量的判断。

提高机器学习精确度的关键在于“输入何种特征量”,然而这只有靠人用大脑思维来解决。

如何选取“特征量”,是机器学习的最大难关。

我们人其实很擅长于抓取特征量。

当我们看见某些相同的对象时,就能够很自然地察觉到其中的内在特征,由此可以更为简单地实现对它们的理解。

或许大家也都经历过这样的情形,比如某个领域的前辈能将某些事情阐述得极为精辟和简练,令人叹服不已。

大道至简,只要能够抓住特征,那么看似复杂的事情也能由此得到梳理,并变得容易理解。

人在视觉信息处理方面也在做着同样的工作。

例如,分辨某个动物是大象还是麒麟、斑马,或者是猫,对人来讲非常简单。

但是要从图像信息里面找出判断这些动物所需的特征对计算机来讲却极为困难。

即使让计算机进行机器学习,它也无法找出合适的特征,因而也就无法实现真正的学习。

既然说到分辨图像,我突然想到:

2012年,在人工智能研究领域发生了一件震撼人心的事情:

[b] 在图像识别领域的国际大赛ILSVRC(大型视觉辨识挑战竞赛)上,首次参赛的加拿大多伦多大学凭借其开发的SuperVision以压倒性优势拔得头筹。在此之前,机器学习时所用特征量的设计都是由拥有专业知识和长年工作经验的研究人员人工完成的。凭借研究者的经验和技能,机器学习的算法和特征量设计才得以一点点地取得进步。2012年,大家的错误率几乎都在26%左右,差距不大但竞争激烈,然而参赛的多伦多大学却一下子将错误率降至15%,领先其他人工智能10个百分点以上,以惊人的优势获得了胜利。那些长年致力于图像识别研究的研究者们对此都惊愕不已。

多伦多大学获胜的秘诀在哪里呢?

原来,其秘诀就在于由该大学的杰弗里·欣顿教授领衔开发的新式机器学习——深度学习。他们独辟蹊径,从与以前那些图像识别研究者完全不同的角度入手,居然一下子就跃至世界顶级水平。[/b]

深度学习以数据为基础,由计算机自动生成特征量。

不需要由人来设计特征量,而是由计算机自动获取高层特征量,并以此来对图像进行分类。

正是由于有了深度学习,人工智能才终于由之前必须借助于人类的领域向前迈出了一步。

深度学习是“人工智能研究50年来的重大突破”。

就像人类一样,刚刚出生的婴儿对于通过眼睛或者耳朵等获取的信息洪流。

应该也是在以惊人的速度不停地进行“运算”。

哪个与哪个是相关的?

哪个又是独立的成分?

从信息洪流之中,通过预测然后再确认答案,反反复复进行这种操作从而发现各种各样的特征量;

之后不久就会发现“妈妈”这个概念,进而发现周围的各种“事物”,并学习它们之间的关系。

就这样,他一点点地去对这个世界进行学习。

这就像谷歌的“猫脸识别”一样。

下图就是谷歌的研究人员在2012年发表的“猫脸识别”研究的示意图。

首先是知识输入,研究者众多视频中提取了1000万张图像,并将其输入计算机。

在下面层级里,计算机还只能识别像点和边线等图像里面常见的“简单图案”。

但是慢慢往上走,便能识别出圆形或者三角形等形状。

然后,作为这些图形的组合,圆形(脸)的中间有两个点(眼睛),两点中间还有一根竖线条(鼻子)。

像这样,逐渐能够得到由复杂图形部件组合而成的特征量。

其结果,在上面层级里面,便出现了类似“人脸”的东西或者类似“猫脸”的东西。

1.我们把提取的图像大量地提供给计算机。

2.机器进行深度学习,它就能够提取特征量。

3.最终获得“人脸”或者“猫脸”等概念。

|

评分

-

查看全部评分

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)