|

|

马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

本帖最后由 混沌未开 于 2018-8-20 11:21 编辑

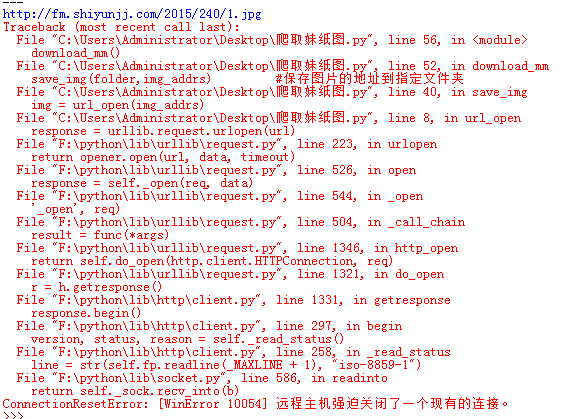

看着小甲鱼的视频学着爬妹子图

但是远程主机关闭。。。。

怎么解决这样的问题啊?

谢谢大佬

代码如下

- import urllib.request

- import os

- def url_open(url):

- req = urllib.request.Request(url)

- req.add_header('User-Agent','Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.90 Safari/537.36 2345Explorer/9.3.2.17331')

- response = urllib.request.urlopen(url)

- html = response.read()

- return html

- def get_page(): #获取页面网址

- url = 'http://www.mmjpg.com/mm/240'

- page_addrs = []

- for i in range(1,20):

- page_url = url + '/' + str(i)

- page_addrs.append(page_url)

-

- return page_addrs

- def find_img(url):

- html = url_open(url).decode('utf-8') #html获取没有问题

-

-

- a = html.find('img src=')

- b = html.find('.jpg',a)

-

- print(html[a + 9:b + 4])

- return html[a + 9:b + 4]

-

-

- def save_img(folder,img_addrs):

- file_name = img_addrs.split('/')[-1]

- with open(file_name,'wb') as f:

- img = url_open(img_addrs)

- f.write(img)

- def download_mm(folder = 'OOXX',pages = 10):

- os.chdir(folder)

- page_url = [] #初始化页面地址列表

-

- page_url = get_page() #获取页面地址

- for each in page_url:

- img_addrs = find_img(each) #找到图片的地址

- save_img(folder,img_addrs) #保存图片的地址到指定文件夹

-

- if __name__ == '__main__':

- download_mm()

会出现这样的错误

|

-

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)