|

|

马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

是这样的,因为有道好像把拉黑了,所以我换了搜狗翻译,但是搜狗翻译这个翻译结果好像是经过加密的。

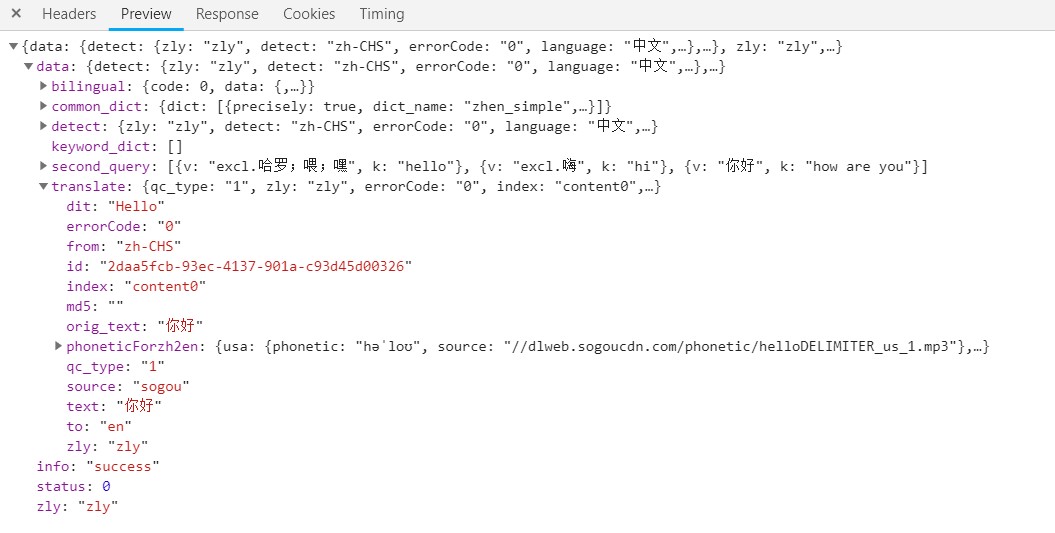

在网页元素审核的notwork里,我找到了翻译结果,就是在translate里dit

但是当我用代码访问并把访问结果打印出来的时候呢,就出问题了

一串乱码,而且每次的乱码不一样。

昨天我就觉得这可能是经过加密啥的,因为在网页dit那里明明就是翻译结果,被代码访问

之后打印出来的就是一串乱码,而且每次不一样。而且我也注意到了末尾有个md5,

只不过不知道是什么东西,看了两眼,也没在意。

但是今天我在别的地方看到md5是一种加密方式,然后我意识到了什么

就去百度,发现有很多解密md5的网站,我就试着把这些乱码去解密。

但是很遗憾,解密不了。

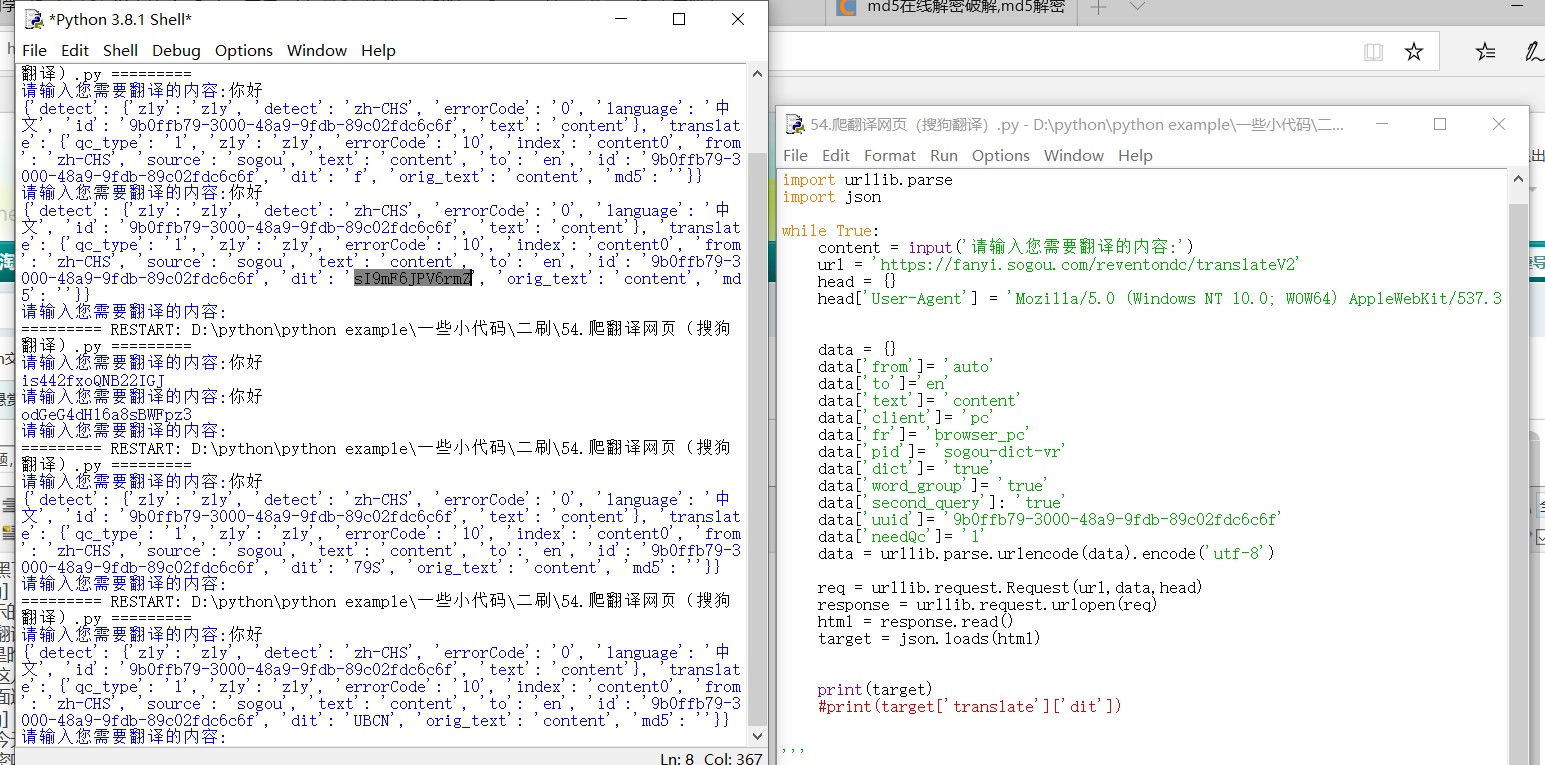

附上我的代码

- import urllib.parse

- import json

- while True:

- content = input('请输入您需要翻译的内容:')

- url = 'https://fanyi.sogou.com/reventondc/translateV2'

- head = {}

- head['User-Agent'] = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3741.400 QQBrowser/10.5.3863.400'

- data = {}

- data['from']= 'auto'

- data['to']='en'

- data['text']= 'content'

- data['client']= 'pc'

- data['fr']= 'browser_pc'

- data['pid']= 'sogou-dict-vr'

- data['dict']= 'true'

- data['word_group']= 'true'

- data['second_query']: 'true'

- data['uuid']= '9b0ffb79-3000-48a9-9fdb-89c02fdc6c6f'

- data['needQc']= '1'

- data = urllib.parse.urlencode(data).encode('utf-8')

- req = urllib.request.Request(url,data,head)

- response = urllib.request.urlopen(req)

- html = response.read()

- target = json.loads(html)

-

- print(target)

- #print(target['translate']['dit'])

有大佬知道是怎么回事吗?到底是不是翻译结果被加密了?如果是,那是不是md5方式呢?

如果是,那也解密不了啊。

本帖最后由 一个账号 于 2020-2-20 19:44 编辑

是啊,我也遇到了这样的问题。这是我的代码:

- import requests

- content = input("请输入待翻译的内容:")

- url = "https://fanyi.sogou.com/reventondc/translateV2"

- data = {"text" : content}

- target = requests.post(url, params=data).json()

- target = target["translate"]["dit"]

- print("翻译结果:", target)

|

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)