|

|

楼主 |

发表于 2024-10-29 16:17:03

|

显示全部楼层

本帖最后由 Terence888 于 2024-10-29 16:20 编辑

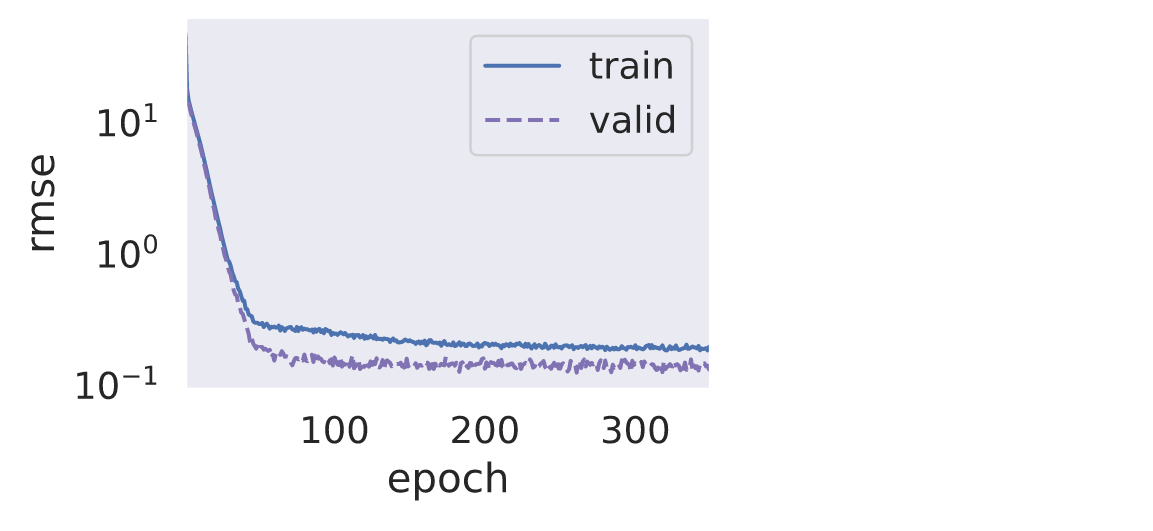

- FOLD 0

- --------------------------------

- Loss: 46.97527987686629 Epoch:0

- Valid Loss: 20.829754419752824 Epoch:0

- Loss: 0.29178172531713736 Epoch:50

- Valid Loss: 0.19511481561406782 Epoch:50

- Loss: 0.24653596320922433 Epoch:100

- Valid Loss: 0.15066531141803846 Epoch:100

- Loss: 0.2153549044300191 Epoch:150

- Valid Loss: 0.14395246001862988 Epoch:150

- Loss: 0.20599480777262003 Epoch:200

- Valid Loss: 0.14863602458611386 Epoch:200

- Loss: 0.1900300081448047 Epoch:250

- Valid Loss: 0.1438508602915351 Epoch:250

- Loss: 0.18739578650169766 Epoch:300

- Valid Loss: 0.1440964142481486 Epoch:300

- FOLD 1

- --------------------------------

- Loss: 0.17494622016280786 Epoch:0

- Valid Loss: 0.17946246701622337 Epoch:0

- Loss: 0.1794223407494653 Epoch:50

- Valid Loss: 0.169219377063394 Epoch:50

- Loss: 0.17596578618505157 Epoch:100

- Valid Loss: 0.17310132480568902 Epoch:100

- Loss: 0.1729663394621967 Epoch:150

- Valid Loss: 0.1520023205128732 Epoch:150

- Loss: 0.16860247088461808 Epoch:200

- Valid Loss: 0.16073557258266763 Epoch:200

- Loss: 0.16632754368470706 Epoch:250

- Valid Loss: 0.1714833322976463 Epoch:250

- Loss: 0.17060728309695253 Epoch:300

- Valid Loss: 0.16290938895182921 Epoch:300

- FOLD 2

- --------------------------------

- Loss: 0.15941910368880047 Epoch:0

- Valid Loss: 0.2035015164986509 Epoch:0

- Loss: 0.1493869949503453 Epoch:50

- Valid Loss: 0.2096995265315898 Epoch:50

- Loss: 0.1526461683495348 Epoch:100

- Valid Loss: 0.2060885189222716 Epoch:100

- Loss: 0.1512634287175444 Epoch:150

- Valid Loss: 0.20573065109883798 Epoch:150

- Loss: 0.14553469501410154 Epoch:200

- Valid Loss: 0.2215843787000761 Epoch:200

- Loss: 0.15290069646646887 Epoch:250

- Valid Loss: 0.22288046521214686 Epoch:250

- Loss: 0.14679287276726818 Epoch:300

- Valid Loss: 0.20940964599860082 Epoch:300

- FOLD 3

- --------------------------------

- Loss: 0.1637262539662856 Epoch:0

- Valid Loss: 0.17200109557187843 Epoch:0

- Loss: 0.15489495624996133 Epoch:50

- Valid Loss: 0.16380020031302245 Epoch:50

- Loss: 0.1579072109305162 Epoch:100

- Valid Loss: 0.17729815804876412 Epoch:100

- Loss: 0.15712214340663858 Epoch:150

- Valid Loss: 0.16706694488468038 Epoch:150

- Loss: 0.15983082779084695 Epoch:200

- Valid Loss: 0.1816392515328332 Epoch:200

- Loss: 0.1570577586639378 Epoch:250

- Valid Loss: 0.17712059473663672 Epoch:250

- Loss: 0.15959430575575614 Epoch:300

- Valid Loss: 0.1791315283050242 Epoch:300

- FOLD 4

- --------------------------------

- Loss: 0.1595115635249623 Epoch:0

- Valid Loss: 0.1718650517082706 Epoch:0

- Loss: 0.1576181186484717 Epoch:50

- Valid Loss: 0.168765833338921 Epoch:50

- Loss: 0.14961974563467542 Epoch:100

- Valid Loss: 0.17768097497343607 Epoch:100

- Loss: 0.15835782148174404 Epoch:150

- Valid Loss: 0.19437884060582755 Epoch:150

- Loss: 0.15468950195820472 Epoch:200

- Valid Loss: 0.17450625626082272 Epoch:200

- Loss: 0.15523005924683667 Epoch:250

- Valid Loss: 0.1721677397637023 Epoch:250

- Loss: 0.1525919285324431 Epoch:300

- Valid Loss: 0.17992113443584376 Epoch:300

- Training Ended

- Train Average Loss: 0.16326146633252245 Valid Average Loss: 0.16873075321982406

损失函数图片如下,我想把训练和验证损失降到0.1以下,要怎么办

|

-

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)