|

|

10鱼币

下面是小甲鱼爬豆瓣top250的代码,有两个个地方没看懂......求大佬解答

1.关于找出多少个页面那,没看懂depth会得到什么为什么要int

2.re模块是什么,速查手册里没有,下面好像也没看到使用

3.评分那怎么append(' 评分:%s '),不应该只要("评分:")吗

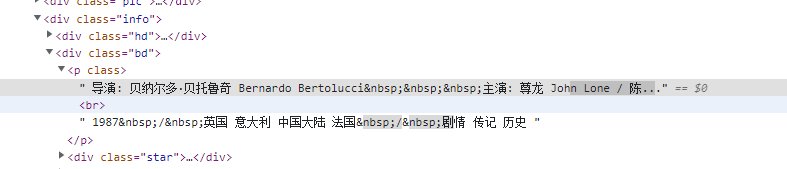

4.资料那个的分切没看懂怎么切的 网页源码在下面的图片里

问题有点多,大佬们挑不麻烦的回复一下吧

import requests

import bs4

import re

def open_url(url):

# 使用代理

# proxies = {"http": "127.0.0.1:1080", "https": "127.0.0.1:1080"}

headers = {'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/57.0.2987.98 Safari/537.36'}

# res = requests.get(url, headers=headers, proxies=proxies)

res = requests.get(url, headers=headers)

return res

def find_movies(res):

soup = bs4.BeautifulSoup(res.text, 'html.parser')

# 电影名

movies = []

targets = soup.find_all("div", class_="hd")

for each in targets:

movies.append(each.a.span.text)

# 评分

ranks = []

targets = soup.find_all("span", class_="rating_num")

for each in targets:

ranks.append(' 评分:%s ' % each.text)

# 资料

messages = []

targets = soup.find_all("div", class_="bd")

for each in targets:

try:

messages.append(each.p.text.split('\n')[1].strip() + each.p.text.split('\n')[2].strip())

except:

continue

result = []

length = len(movies)

for i in range(length):

result.append(movies[i] + ranks[i] + messages + '\n')

return result

# 找出一共有多少个页面

def find_depth(res):

soup = bs4.BeautifulSoup(res.text, 'html.parser')

depth = soup.find('span', class_='next').previous_sibling.previous_sibling.text

return int(depth)

def main():

host = "https://movie.douban.com/top250"

res = open_url(host)

depth = find_depth(res)

result = []

for i in range(depth):

url = host + '/?start=' + str(25 * i)

res = open_url(url)

result.extend(find_movies(res))

with open("豆瓣TOP250电影.txt", "w", encoding="utf-8") as f:

for each in result:

f.write(each)

if __name__ == "__main__":

main()

[/i][/i]

本帖最后由 isdkz 于 2023-5-2 16:34 编辑

1. 关于找出多少个页面的问题:在这个代码中,页面是通过在url中传入参数start来控制的,每页默认显示25条数据。在函数find_depth中,使用BeautifulSoup解析res.text得到soup对象,再通过soup.find()方法找到class为"next"的span标签,然后通过previous_sibling.previous_sibling属性找到该标签前面的兄弟标签,即包含总页数的标签,使用.text属性获得该标签中的文本内容,也就是总页数。但是,soup.find()方法返回的是一个Tag对象,而该对象的previous_sibling.previous_sibling属性返回的是一个NavigableString对象,该对象的text属性返回的才是包含总页数的文本内容。由于该文本内容是数字字符串,需要使用int()函数将其转换为整数类型,作为返回值。

2. 关于re模块的问题:re模块是Python中用于进行正则表达式操作的模块。在这个代码中没有直接使用到re模块,但是在其他程序中可能会用到。例如,当需要从一段文本中提取出满足特定格式要求的字符串时,可以使用re模块的正则表达式匹配功能进行提取。

3. 关于评分那里的问题:这里的代码使用了字符串的格式化功能,将每个电影的评分信息格式化为字符串后,使用append()方法添加到ranks列表中。'%s'是格式化字符串的占位符,表示在该位置处填入一个字符串,使用%运算符将要填入的字符串传入即可。在这个代码中,ranks列表中的每个元素是一个字符串,格式为"评分:x.x"。

4. 关于资料那里的问题:在这里,使用了字符串的split()方法对每个电影的资料进行分割。对于每个包含电影资料的标签,其p标签中的文本内容都是按照一定的格式排列的,其中第2行和第3行分别包含了电影的年份和导演信息。使用split('\n')方法将文本内容按行分割成一个列表,然后使用[1]和[2]索引提取出第2行和第3行,使用strip()方法去除空白字符后,使用"+"号将两个字符串拼接成一个字符串,作为该电影的资料信息。

|

-

最佳答案

查看完整内容

1. 关于找出多少个页面的问题:在这个代码中,页面是通过在url中传入参数start来控制的,每页默认显示25条数据。在函数find_depth中,使用BeautifulSoup解析res.text得到soup对象,再通过soup.find()方法找到class为"next"的span标签,然后通过previous_sibling.previous_sibling属性找到该标签前面的兄弟标签,即包含总页数的标签,使用.text属性获得该标签中的文本内容,也就是总页数。但是,soup.find()方法返回的是一个Tag对象 ...

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)