|

|

马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

"Transformer"模型是一种深度学习架构,由Ashish Vaswani等人在2017年的论文《Attention Is All You Need》中首次提出。

该模型主要应用于自然语言处理(NLP)领域,特别是在机器翻译任务中取得了突破性进展。

在线学习:

Transformer模型的一些关键特点:

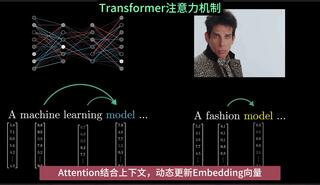

- 自注意力机制(Self-Attention):Transformer模型的核心是自注意力机制,它允许模型在编码和解码过程中同时关注序列中的所有位置,而不是像循环神经网络(RNN)那样按顺序处理。

- 并行处理:由于自注意力机制的特性,Transformer可以并行处理序列中的所有元素,这使得它在训练速度上比传统的序列模型(如RNN和LSTM)快得多。

- 编码器-解码器架构:Transformer模型通常由编码器(Encoder)和解码器(Decoder)组成。编码器将输入序列转换成一个连续的表示,解码器则基于编码器的输出和之前生成的输出来生成目标序列。

- 多头注意力(Multi-Head Attention):Transformer模型使用多头注意力机制,可以同时从不同的表示子空间捕捉序列的信息。

- 位置编码(Positional Encoding):由于Transformer缺乏递归和卷积结构,它使用位置编码来提供序列中单词的位置信息。

- 前馈网络(Feed-Forward Networks):在每个编码器和解码器层中,自注意力层的输出会通过一个前馈神经网络进行进一步的处理。

- 层归一化(Layer Normalization)和残差连接(Residual Connections):Transformer模型使用层归一化来加速训练过程,并使用残差连接来帮助梯度流动,避免深层网络中的梯度消失问题。

- 可扩展性:Transformer模型的设计允许它很容易地扩展到更大的模型尺寸和更多的层数,这使得它可以捕获更复杂的语言模式。

- 广泛应用:自Transformer模型提出以来,它已经被广泛应用于各种NLP任务,包括文本分类、问答系统、文本摘要、情感分析等。

- 变体和扩展:基于原始的Transformer模型,研究者们提出了多种变体和扩展,如BERT(Bidirectional Encoder Representations from Transformers)、GPT(Generative Pre-trained Transformer)等,这些模型在不同的任务和领域中都取得了显著的成果。

Transformer模型的出现标志着NLP领域的一个重要转折点,它为 |

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)